-

빅테크

빅테크[공간사회학] 세계 최초 AI 예술 박물관, LA에 내년 봄 개관…"DATALAND, AI와 인간 상상력의 만남"

[뉴스스페이스=이종화 기자] 세계 최초의 AI 예술 박물관인 데이터랜드(DATALAND)가 2026년 봄, 프랭크 게리(Frank Gehry) 설계의 그랜드 LA 복합 시설 내 로스앤젤레스 다운타운에 개관한다. blooloop, Los Angeles Times, TimeOut Los Angeles, DesignBoom에 따르면, 이 소식은 레픽 아나돌 스튜디오(Refik Anadol Studio)가 최근 공식 발표한 것으로 당초 2025년 개관 예정에서 1년 연기됐다. DATALAND의 총 연면적은 약 2만5000평방피트(약 2320㎡) 규모로, 5개의 독특한 갤러리로 구성된다. 박물관의 핵심 전시 공간인 갤러리 C의 '인피니티 룸'은 2014년 UCLA에서 처음 제작된 Anadol의 대표 설치작을 진화시킨 버전이다. 이 공간은 정육면체 모양의 미러링 벽면과 바닥, 천장을 갖추고 있으며, AI가 생성한 빛과 데이터를 미디어 아트로 구현한다. 이번 DATALAND 버전에는 AI가 자연 데이터를 기반으로 생성한 향기까지 도입되어, 몰입형 예술 체험으로서의 혁신을 보여준다. 이 향기는 스튜디오가 개발한 대규모 자연 데이터 기반 오픈 소스 AI 'Large Nature Model'에서 추출된 것이다. Large Nature Model은 스미소니언, 런던 자연사박물관, 코넬 조류학 연구소 등 세계 유명 자연 과학 기관들의 데이터 900만 공공 표본 기록과 6300만장의 이미지, 최대 5억장에 달하는 자연 이미지 빅데이터를 활용해 개발된 세계 최초의 자연 특화 AI 생성 모델이다. 이 AI는 물리학과 공간 역학을 이해하는 고급 생성형 AI 'World Models' 기술을 세계 최초로 몰입형 환경에 적용하며, 환경과 기술의 결합을 통해 예술과 자연의 새로운 조화를 시도한다. 모든 데이터는 윤리적 허가를 받고 사용되었으며, 연구는 재생에너지 기반의 구글 서버에서 진행됐다. 문화적 위치 측면에서, DATALAND는 월트 디즈니 콘서트 홀 건너편 그랜드 LA에 자리하며, The Broad, MOCA, The Music Center 등 LA의 주요 문화예술기관들과 어깨를 나란히 하는 전통적인 예술 지역의 중심지에 들어선다. 이는 2018년 동명의 WDCH Dreams 프로젝트를 디즈니 콘서트 홀에 투사했던 Refik Anadol과 공동 설립자 Efsun Erkılıç에게 상징적 귀향의 의미도 갖는다. 박물관은 구글 아트앤컬처(Google Arts & Culture)와 협력해 첫 아티스트 레지던시 프로그램을 시작한다. 이 프로그램은 총 6개월 동안 3명의 예술가가 AI와 인간 창의성의 융합을 탐구하며, 최종 결과물을 DATALAND에서 일반에 공개하는 것을 목표로 한다. 프로젝트 참여자들에게는 멘토링, 자금 지원, 최첨단 기술 자원이 제공된다. 이를 통해 AI가 어떻게 문화 및 예술 내 서사를 확장할 수 있는지 대중의 이해를 높이고자 한다. 전문가들은 "DATALAND를 통해 AI 예술이라는 신생 장르가 예술문화계에 미칠 심오한 영향과 LA의 문화적 위상 강화에 큰 기대를 걸고 있다"며 "AI와 인간 창의성의 경계를 허무는 이 시도는 예술 창작의 미래를 재정의하는 새로운 이정표가 될 것"이라고 평가했다.

-

Culture·Life

Culture·Life[내궁내정] 10월 26일, 동서양 정치거물의 탄생과 파국…박정희·노태우·이토 히로부미 사망, 힐러리·미테랑·트로츠키 출생

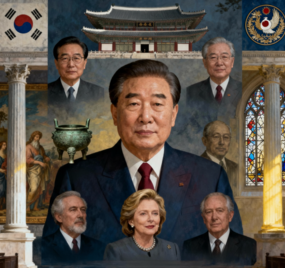

[뉴스스페이스=이종화 기자] <편집자주> 유튜브, 인스타 등에서 활동하는 인플루언서들이 '협찬을 받지 않았다', '광고가 아니다'라는 사실을 보이기 위해 "내 돈 주고 내가 샀다"라는 뜻의 '내돈내산'이라는 말이 생겼다. 비슷한 말로 "내가 궁금해서 결국 내가 정리했다"는 의미의 '내궁내정'이라고 이 기획코너를 명명한다. 우리 일상속에서 자주 접하는 소소한 얘기거리, 궁금증, 호기심, 용어 등에 대해 정리해보는 코너를 기획했다. 10월 26일 일요일, 전 세계 주요 이슈는 미국의 외교 전략과 아시아의 국제정세에 관심이 모아진 가운데 트럼프 대통령이 “북한은 사실상 핵보유국이다. 김정은 위원장이 준비되면 만날 용의 있다”고 발언하면서 한반도 정세가 들썩였다. 이는 APEC 회의가 열리는 경주 인근에서 미중 정상회담이 예정된 가운데 나온 발언으로, 외교적 파장이 예상된다. 역사적으로 10월 26일은 국내외 정치 역사에서 의미가 큰 날이다. 왜냐하면 10월 26일은 세계적으로 ‘운명의 아이러니’가 깃든 날짜로, 역사적 거물의 탄생과 죽음이 맞닿은 날이다. 힐러리 클린턴 미국 대통령 후보, 미테랑 프랑스 대통령, 러시아 볼셰비키 혁명 지도자로 스탈린에 의해 추방 및 암살된 리언 트로츠키가 태어난 날이자, 박정희·노태우 두 한국 대통령이 세상을 떠나고, 일본의 이토 히로부미가 안중근 의사에게 피살된 날이기 때문이다. 10월 26일에 사망한 유명 인물로는 우선 박정희 제 5~9대 대통령이 1979년 10·26 사건으로 김재규 중앙정보부장에게 피살됐다. 공교롭게 노태우 제13대 대통령도 2021년 병중 끝에 10월 26일 별세했다. 한국의 대통령 2명이 같은 날 운명을 달리한 셈이다. 한 정치평론가는 "10월 26일은 한국 현대사에서 ‘박정희 피살 → 노태우 사망’이라는 군사정권의 비극과 종식이 같은 날 반복된다는 점에서 강렬한 역사적 아이러니로 남는다"고 논평했다. 일본 정치인이자, 초대 조선통감인 이토 히로부미도 1909 하얼빈역에서 안중근 의사에게 피살된 것도 이 날이다. 미국의 여성인권운동의 선구자, 서프러지스트협회 공동 설립자였던 엘리자베스 케이디 스탠턴도 이날 사망했다. 이외에도 《바람과 함께 사라지다》로 흑인 최초 오스카 수상자인 하티 맥대니얼 미국 배우(1952년), 할리우드 음악계 대표 싱어송라이터로 활약한 호이트 액스턴 미국 포크 가수(1999년), DNA 합성 효소 발견으로 노벨 생리의학상 수상한 아서 콘버그 미국 생화학자(2007년), ‘피노키오의 모험’ 창작자인 카를로 콜로디 이탈리아 작가(1890년), 1950~60년대 ‘브리티시 록’의 여왕이었던 영국 팝가수인 알마 코건(1966년)도 10월 26일에 사망했다. 이처럼 역사적으로 10월 26일은 동양과 서양의 근현대 정치사와 문화사의 비극과 창조가 맞물린 날로 평가된다. 특히 한국에서는 ‘10·26 사태’로 인해 정치사적 분기점이 됐으며, 서구에서는 여성 참정권 운동가 스탠턴과 예술계 거물들의 죽음이 같은 날에 맞물린 것이 이례적이다. 반면 10월 26일에 태어난 유명인도 많다. 미국의 전 국무장관이자 민주당 대선후보로 여성 정치 리더의 상징인 힐러리 로드햄 클린턴(1947년)의 생일이 이 날이다. 또 프랑스 출신으로 유럽 통합을 이끈 사회당 지도자였던 프랑수아 미테랑 프랑스 대통령(1916년)도 이 날 태어났다. 러시아 볼셰비키 혁명 지도자로 스탈린에 의해 추방 및 암살된 리언 트로츠키 러시아 혁명가(1879년), 르네상스 인문주의의 기틀을 마련한 사상가 데시데리우스 에라스무스 네덜란드 인문학자(1466년) 역시 이 날 탄생했다. 그래미상 수상자이자, 니콜 키드먼 남편인 키스 어번 호주 출신 컨트리 가수(1967년), 《패밀리 가이》, 《더 오빌》 창작자인 세스 맥팔레인 미국 애니메이터·프로듀서(1973년), WWE·UFC 출신으로 엔터테인먼트 대표 인물인 CM 펑크 (필 브룩스) 미국 프로레슬러(1978년)도 이 날 태어났다. 《찰리의 천사》 주연, 패션 사업가로 성공한 미국 배우 자클린 스미스(1945년), 『Think and Grow Rich』 저자인 나폴레온 힐 미국 자기계발 작가(1883년), “가스펠의 여왕”으로 불림린 마할리아 잭슨 미국 가스펠 가수(1911년), 배우 딜런 맥더모트, 리타 윌슨, 패트 세잭(‘Wheel of Fortune’ 진행자) 등도 모두 이날 태어났다.

-

공간·건축

공간·건축[공간사회학] 독도의 날(10월 25일)에 알아본 작은 섬이 품은 거대한 의미·흥미·재미 13가지

[뉴스스페이스=이종화 기자] 10월 25일은 대한민국 최동단의 섬 독도를 기념하는 ‘독도의 날’이다. 단 하루의 기념일이지만, 그 안에 담긴 125년의 역사는 한 국가의 근대화, 주권, 자긍심을 압축해 보여준다. 대한민국의 영토 가운데 가장 작은 섬, 그러나 그 존재감은 가장 크다. 독도는 매년 수많은 뉴스에 오르내리지만, 그 심해와 땅속, 그리고 그곳을 지켜온 이름 없는 사람들의 이야기는 여전히 베일에 싸여 있다. 1. 대한제국 칙령 제41호에서 시작된 날 1900년 10월 25일. 대한제국 고종 황제는 칙령 제41호를 반포해 울릉도를 ‘울도군(鬱島郡)’으로 승격시키고 그 관할 구역에 죽도(竹島)와 석도(石島)를 포함시켰다. 여기서 석도가 바로 오늘날의 독도다. 이날을 기념하기 위해 2000년 민간단체 ‘독도수호대’가 ‘독도의 날’을 제정했다. 2. 동해를 품은 독도의 생태·지질학적 가치 독도는 단순한 바위섬이 아니다. 460만년 전 용암이 굳어 형성된 화산섬으로, 해저산의 진화 과정을 보여주는 세계적 지질유산으로 평가받는다. 섬 전체가 화산암과 화산쇄설성 퇴적암류로 구성되어 있으며, 1982년 천연기념물 제336호로 지정됐다. 동도(높이 98.6m)와 서도(높이 168.5m)를 중심으로 89개의 바위섬이 흩어져 있어 총 91개의 섬으로 이루어진다. 이곳에는 괭이갈매기를 비롯한 150여 종의 조류와 희귀 식물, 해양생물이 서식하며, 독도 주변 해역은 해삼·문어·대구 등 어장이 형성된 풍부한 생태 보고이기도 하다. 3. 해양주권의 상징, 그리고 안보의 최전선 독도는 지정학적으로 대한민국의 ‘해양주권 전초기지’다. 한국해양과학기술원 조사에 따르면, 만약 독도를 상실할 경우 남한 면적의 60%에 해당하는 해양영토(약 6만574㎢)를 잃게 된다. 또한 북태평양 방위 체계상 한국·일본·러시아의 해상항로가 교차하는 요충지로, 군사·안보적으로도 전략적 가치가 막대하다. 러일전쟁 시기 일본군이 독도를 군사용 중계기지로 점거하려 한 기록이 남아 있듯, 이 작은 섬은 과거부터 동북아 세력 균형의 핵심 축이었다. 4. 2000m 아래 숨은 수중화산의 비밀 사람들이 눈으로 보는 독도는 전체의 3%에 불과하다. 수면 아래에는 실제로 ‘독도 해산’이라 불리는 거대한 화산체가 자리 잡고 있다. 이 해산의 깊이는 무려 2000m. 과학자들은 “독도는 이미 사라진 거대 화산의 마루 부분”이라며, 지질학적으로 동해판의 움직임을 연구하는 핵심 포인트라 평가한다. 독도 서쪽 아래에는 ‘탐해해산’과 ‘동해해산’이 존재해, 독도가 사실상 바닷속 거대한 화산지대의 꼭대기라는 점도 흥미롭다. 5. 메탄하이드레이트, 바다 밑의 ‘하얀 황금’ 독도 인근 해저에는 천연가스의 대체 자원으로 불리는 메탄하이드레이트가 6억톤 규모로 매장돼 있다. 한국지질자원연구원 조사에 따르면 개발 가치만 최소 300조원 규모에 달한다. 메탄하이드레이트는 얼음 속에 천연가스가 갇힌 고체 에너지로, 일본과 중국이 독도를 탐내는 이유 중 하나로 꼽힌다. 이 ‘바다 밑의 백금’은 향후 한국의 에너지 안보와 직결된 숨은 보물이다. 6. 생존과 저항의 기억, 독도 해녀와 어부들 1940년대부터 1970년대까지, 제주의 해녀들이 생계를 위해 독도까지 건너와 물질했던 사실은 오랫동안 알려지지 않았다. 그들은 바위굴에 머물며 세 달 이상 해조류와 전복을 채취했고, 바람과 파도 속에서도 바다와 싸웠다. 해녀들의 ‘독도 생활사’는 독도의 실효지배가 단순한 행정적 개념이 아니라, 사람의 몸으로 증명된 역사라는 점을 보여준다. 7. 멸종된 ‘독도 강치’, 바다의 수호신이 남긴 흔적 100여년 전, 독도는 강치(바다사자, Eumetopias jubatus stelleri)의 천국이었다. 한때 4만 마리가 넘는 강치가 서식했으나, 1905년 일본 어선들이 가죽과 지방을 얻기 위해 1만4000마리가량을 대량 포획하면서 멸종됐다. 독도 해안 절벽 주위에는 지금도 강치의 뼈가 발견되기도 하며, 이들은 ‘독도의 수호신’이라 불린다. 강치의 멸종은 독도가 겪은 ‘침탈의 기억’을 상징하는 생태적 증언이다. 한국과 일본 모두 ‘독도 강치의 멸종을 인정하고 있으며, 일본 시마네현에도 표본 박제가 보존되어 있다. 8. 1만2000그루의 나무, 그리고 단 30그루 생존 1990년대 초, 독도를 푸르게 만들기 위한 식수 사업이 추진됐다. 울릉도에서 1만2000그루의 나무를 옮겨 심었지만, 강한 염분과 거센 바람, 토양 부족으로, 거의 대부분 고사했고 생존률은 극히 낮다(1% 이하). 그럼에도 불구하고 섬초롱꽃, 독도사철나무, 참소리쟁이 등은 여전히 낮게 엎드려 생존 중이며, ‘바위에 뿌리내린 존재의 은유’로 읽힌다. 9. 독도의 진짜 주인 ‘괭이갈매기’ 봄이면 독도는 괭이갈매기의 왕국이 된다. 약 1만 마리가 독도를 뒤덮고, 서로 둥지 자리를 두고 싸우기도 한다. 새끼가 태어나 성체가 될 때까지 독도를 떠나지 않는 까닭에 ‘봄의 주인은 갈매기’라 불린다. 최근에는 동해 수온 상승으로 괭이갈매기의 산란 시기가 점차 앞당겨지고 있으며, 이는 기후위기의 징후로 해양생태 변화의 상징처럼 불린다. 10. 한반도에서 가장 먼저 해가 뜨는 ‘시간의 섬’ 독도는 대한민국에서 해가 가장 먼저 떠오르는 땅이다. 1월 한겨울이면 오전 7시 26분경, 동도 정상에서 첫 햇살이 수평선을 가른다. 독도의 일출은 한국 천체관측 기준점 중 하나로 기록되어 있으며, ‘시간의 시작점’이라는 신화적 의미까지 지닌다. 다만 하지철에는 위도가 달라 울릉도 또는 함경북도 나진 인근이 더 빠르다. 11. 독도의 심해, 미지의 생명체가 사는 곳 KBS 다큐팀이 심해 2600m를 탐사한 결과, 이전에는 확인되지 않았던 신종 심해생물들이 포착됐다. 바다 밑에는 형형색색의 해면동물, 산호류, 그리고 미확인 희귀 심해생물들이 존재하며, 이는 우리나라 바다 생물주권의 새로운 연구대상으로 떠오르고 있다. 12. 독도의 문화·역사와 유래 독도는 512년 신라 지증왕 때 이사부 장군이 우산국을 정벌하면서 우리 영토로 포함시킨 이후 여러 문헌에 ‘우산도(于山島)’·‘삼봉도(三峰島)’ 등으로 등장한다. 흥미롭게도 19세기 서양 항해자들은 이 섬을 프랑스 탐사선 ‘리앙쿠르호’의 이름을 따 ‘리앙쿠르 암초(Liancourt Rocks)’라고 기록했다. 또 독도의 이름 ‘독(獨)’은 경상도 방언 ‘돌섬(독섬)’에서 비롯됐다. 돌로 이루어진 섬이라는 의미가 세월을 건너 한자로 옮겨지며 ‘독도(獨島)’로 정착된 것이다. 13. 오늘의 독도, 내일의 바다 현재 독도에는 독도경비대, 등대관리원, 울릉군 공무원 등을 포함해 약 40여명이 상주하며 실효지배를 이어가고 있다. 연간 20만명 이상이 입도 신고를 하고 방문할 정도로 국민의 발길도 끊이지 않는다. 독도는 단지 동해 한가운데 떠 있는 섬이 아니다. 125년 전 고종의 칙령이 품었던 ‘자주국가의 선언’이 오늘날 주권의 실천으로 이어지고 있으며, 한반도의 물리적 공간을 넘어 정신적 영토가 되어가고 있다. 오늘 10월 25일, ‘독도의 날’은 공간사회학적으로 한 국가의 정체성과 기억이 물질적 공간 위에서 어떻게 재구성되는지를 보여주는 상징적 사례다. 울릉도에서 동해를 바라볼 때, 저 멀리 떠오르는 두 개의 바위섬은 단지 섬이 아니다. 그것은 ‘대한민국의 의지’ 그 자체다. 두 점의 바위가 만든 복합영역 ‘독도’는 단순한 영토가 아니라, 기억과 생태와 인간의 시간이 층층이 쌓인 ‘살아 있는 기록 장치’다. 공간사회학의 시선으로 보면, 독도는 물리적 장소를 넘어 ‘국가적 정체성의 기억 장소(lieux de mémoire)’이다. 그 바위 위에서, 그리고 그 바다 밑에서 대한민국은 여전히 숨 쉬고 있다.

-

공간·건축

공간·건축[지구칼럼] '은행나무' 관찰·성찰·통찰…가로수 1위·암나무만 열매·은행털이(?)기계·멸종위기종·암수감별·성전환수술(?)·神木

[뉴스스페이스=이종화 기자] "전 궁중악사 종문이예요 미단공주와 뒤뜰에서 놀다 빨래줄에 걸린 이불숲속에서 키스하던 순간 천년을 기다려도 이루어지지 않는 사람이 있습니다 10억년도 지나고 나면 한 순간 이 순간이 지나면 우린 영원히 다시 만나게 될거예요" - 영화 '은행나무 침대' 중에서 - 서울 시내 가로수 40만그루 가운데 은행나무가 가장 많다. 대략 30~40%정도 차지한다. 어디서든 적응해 왕성하게 잘 자라기때문에 가로수에 매우 적합한 나무다. 2위는 버즘나무(플라타너스), 3위는 느티나무, 4위는 벚나무 3만2641그루 순이다. 은행나무가 도심에 많은 이유는 공해나 병충해에 강하고 수명이 길다. 게다가 가을이면 노란색 단풍의 멋진 자태를까지 자랑하며 시민들에게 볼거리까지 제공한다. 게다가 이산화탄소 흡수 능력이 뛰어나고 질소·아황산가스 등 공기 중의 나쁜 성분을 잘 정화한다. 냄새가 강해서 벌레도 적게 꼬여 병충해에 강하다. 은행나무는 목재로써 활용도도 높다. 결이 곱고 탄력성이 높아 가구나 바둑판 등으로 많이 쓰인다. 은행나무는 멸종위기종으로 지정돼 보호가 필요한 상황이라, 암나무가 피해를 준다고 함부러 베어서는 안된다. 은행나무 과에는 오직 은행나무 1속, 1종만이 있을 뿐이다. 은행나무는 고생대부터 있었고 쥐라기가 전성기였던 화석식물이다. 빙하기에는 대부분의 식물들이 사라졌지만 비교적 따뜻했던 중국 절강성 부근에 살아남아 이제 한반도 전역에서 제2의 전성기를 보내고 있다. 은행나무는 매년 9~10월 열매를 맺는다. 은행잎은 혈액순환 촉진 성분이 있어 뇌기능, 말초혈관 개선 등의 약 재료로 쓰이지만 열매 역시 혈행개선에 좋다고 알려졌다. 하지만 가로수 은행나무의 특유의 냄새와 악취는 서울시 가을 민원의 상당 부분을 차지할 정도로 골치거리다. 열매가 밟혀 터지면 냄새가 더 심해지고 거리도 지저분해진다. 은행 열매가 악취를 내는 것은 은행 껍질에 있는 은행산과 빌로볼 성분 때문이다. 고약한 구린내를 풍겨 곤충으로부터 씨앗을 보호한다. 열매는 암나무에서만 열린다. 은행이 열리는, 은행이 떨어져 있는 나무가 암나무다. 암나무가 가장 많은 자치구는 서울 송파구다. 당연히 민원도 가장 많다. ‘은행나무도 마주서야 연다’는 속담처럼, 은행나무는 동물처럼 암수가 따로 있는 나무다. 조상들은 은행나무를 서로 바라보기만 해도 사랑이 오가 열매를 맺는 나무로 여겼다. 그 이유는 수꽃의 꽃가루가 스스로 움직여 암꽃을 찾아가는 방식이다. 서울시는 악취 문제를 해결하기 위해 매년 심각한 고민을 해왔다. 서울시는 25개 구청에 “은행 열매가 떨어지기 전에 미리 털어달라”고 공문을 매년 발송한다. 최근엔 은행털이(?) 기계를 도입해 강제로 은행열매를 떨어뜨린다. 원래 가로수 열매는 채취할 수 없게 돼 있지만, 은행나무는 예외로 인정한다. 은행이 떨어지기 전에 주민들이 따가는 것도 권고한다. 은행 미리 털기, 은행 주워가기 등의 방법보다 근본적으로 가장 좋은 방법은 암나무를 수나무로 교체하는 것이다. 문제는 예산이다. 한 그루를 바꿔 심는 데 200만원가량이 든다. 적지 않은 비용 때문에 지하철 출입구, 횡단보도 주변등 통행량이 많은 지역중심으로 수나무로 매년 조금씩 교체중이다. 그렇다면 심을때 아예 수나무를 심지, 왜 암나무를 심어서 고생하냐고 물어보는 사람이 있다. 종전까지 인간의 기술로는 은행나무의 암수를 구분하기 어려웠다. 은행나무는 보통 20~30년 지나야 꽃이 피기 시작하고 열매가 열려야 암수를 구별할 수 있다. 서울시 조경과 담당자는 "은행나무의 암수 구별은 쉽지 않다. 10년 이상 자라 열매가 달려야 암나무임을 확인할 수 있다"며 "옛날에는 수나무는 가지가 하늘로 뻗고 암나무는 옆으로 퍼진다는 조경업자들의 감별법에 따라 수나무를 골라 심었다. 하지만 정확하지 않아 암나무를 완벽하게 골라내지 못했다"고 회고했다. 하지만 국립산림과학원이 2011년 암수나무 조기식별 DNA분석 기술을 개발했다. 2014년 국내 특허 등록을 마친 이 기술은 현재 민간기업에 기술이전까지 마친 상태다. 가로수용 은행나무 ‘이룸1호’가 주인공이다. 요즘 시골에서는 열매를 맺는 암나무를, 도시에서는 악취를 풍길 우려가 없는 수나무를 심는다. 서울시는 암나무를 열매가 열리지 않는 수나무로 바꿔 심는 정책을 추진중이다. 지하철 출입구나 버스 정류장, 횡단보도 주변 등 민원이 많이 발생하는 곳을 중심으로 암나무를 수나무로 교체한다. 최근에는 심지어 성전환 수술(?)까지 이뤄진다. 전남 광양시 우산웰빙테마공원 은행나무엔 ‘은행나무 암수 전환 수술 중’이라는 푯말이 꽂혀 있다. 접목(接木)을 가로수에 적용해 암나무에서 은행 열매가 생기지 않도록 수술(?)을 시행중이다. 은행나무는 신목(神木)이다. 양평 용문사 높이 60미터 1200살 은행나무는 8.15해방 직전 두 달간 울었고 6.25사변 때는 50일간 울었는데 십리 밖까지 그 소리가 들렸다는 전설이 있다. 은행을 맺지않는 은행나무에 대한 조선시대 전등사 비화도 있다. 숭유억불 정책을 펼치던 조선시대, 전등사도 예외없이 탄압의 대상이었다. 관리들과 토호들의 탐욕으로 젊은 스님들은 강화성을 쌓는 데 사역을 나가고, 늙은 스님들은 종이를 만들어 바쳐야 했다. 전등사에 있는 2그루 은행나무 때문에 매년 은행을 진상으로 바치고 나면 남는 게 없었다. 다 털어도 10가마니밖에 안 될 판에 20가마니를 바치라는 조정의 명령에 전등사가 난리가 났다. 승려들은 은행나무 아래에 단을 쌓아두고 3일기도를 올렸다. "오늘 3일기도를 마치며 이 은행나무 2그루가 100년이 지나도 1000년이 지나도 영원히 열매 단 한 알도 맺지 아니하기를 원하나이다"라고. 이후 은행나무 2그루는 은행을 맺지 않게 되었고 관가의 탄압도 없어졌다. 은행을 맺지 않는 은행나무들은 노승나무와 동승나무로 불린다. 은행열매, 은행나무잎, 은행나무 어느 것 하나 버릴 것이 없다. 아래는 안도현 시인의 '너에게 묻는다'라는 시이다. 아래 시 연탄재를 은행나무(은행잎, 은행열매)로 바꿔도 전혀 의미에서 차이가 없다. 연탄재 함부로 발로 차지 마라 너는 누구에게 한 번이라도 뜨거운 사람이었느냐

최신뉴스

-

경제·부동산

경제·부동산[랭킹연구소] 서울시 생활만족지수 25개 자치구 순위…서초구>광진구>송파구>강남구>성동구 順

-

빅테크

빅테크[The Numbers] JP모건 "스트라이프, AI와 암호화폐 혁신으로 3500억 달러 시장 선점할 것" 전망

-

빅테크

빅테크[랭킹연구소] 에테나의 USDe, 디지털 달러 시장 3위로 급부상…USDT·USDC에 도전장

-

공간·건축

공간·건축[공간혁신] 80년간 보물창고 감춰졌던 피카소 ‘꽃 모자 여인’, 500억원에 낙찰…"올해 파리 경매 최고가"

-

빅테크

빅테크[빅테크칼럼] "테슬라 10년 내 사라진다" 前 스텔란티스 CEO의 충격적 경고…"BYD에 밀려, 머스크는 자동차 산업 떠날 것"

-

산업·유통

산업·유통[랭킹연구소] 테슬라에도 밀린 중견 한국GM·르노·KG모빌리티, 내수 부진 심화로 올해 10만대 턱걸이 전망

-

공간·건축

공간·건축[공간혁신] 佛 이브 클랭, 독보적 파란 단색화 ‘California' 308억원 낙찰…"미술계 경매 새 기록"

-

우주·항공

우주·항공[기사제목] 선박도 무인 자율운항 시대…美 사로닉-엔비디아, AI 기반 해양 자율운항 선박 개발

-

우주·항공

우주·항공[우주AtoZ] 일본 대형로켓 H3 7호기, 신형 무인 보급선 HTV-X 첫 탑재 발사 성공…ISS 향한 3일간 비행 시작

-

우주·항공

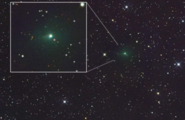

우주·항공[우주AtoZ] NASA, 맨해튼 크기의 혜성에서 외계 신호 추적… 외계 가능성 놓고 세계 과학계 긴장

-

공간·건축

공간·건축[이슈&논란] 마드리드에서 실종된 피카소 그림 찾았다…1919년作 ‘기타가 있는 정물화’ 실종 아닌 누락

-

공간·건축

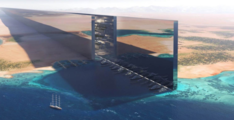

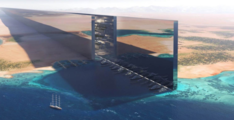

공간·건축[빅테크칼럼] 사우디아라비아, 5000억 달러 네옴 메가시티에서 AI 투자로 오일머니 이동…"석유경제 탈피, 기술경제 다각화"

-

빅테크

빅테크[빅테크칼럼] 소프트뱅크, 225억 달러 추가 투자로 오픈AI 대규모 지원 완성…AI 인프라 투자 '스타게이트 프로젝트' 가속

-

Culture·Life

Culture·Life[이슈&논란] 부커상 재단, 첫 어린이 문학상 출범…"심사위원도 어린이" 아동문학 새 역사 쓴다

-

경제·부동산

경제·부동산[The Numbers] 한국 금융소득 상위 2%, 매년 1인 21억원 벌어…"배당소득 집중현상"

-

Culture·Life

Culture·Life[영웅시대] 트래비스 스캇, 지진보다 강한 '서울 콘서트' 예고…4만5000명 열광에 '음악지진' 일어날까

-

빅테크

빅테크[빅테크칼럼] 1812년 나폴레옹 60만 군대 휩쓴 참극의 진실…DNA가 밝힌 '질병의 블랙박스' 新감염병

-

빅테크

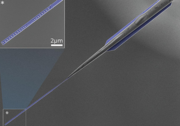

빅테크[빅테크칼럼] 퀸즐랜드大, 쌀알보다 작은 칩 위에 '미세한 바다' 만들다…우르셀 1억 ‘초유체 파동’ 혁신

-

우주·항공

우주·항공[이슈&논란] 美 쉴드 AI, 수직 이착륙 AI 전투기 'X-BAT' 공개…'공중전 패러다임' 바꾼다

-

빅테크

빅테크[빅테크칼럼] 중국 Pony.ai, 혁신적 제조로 300번째 로보택시 생산…올해 1000대 자율주행차 목표 달성 '박차'

-

[빅테크칼럼] 테슬라 '매드 맥스' 모드, 제한속도 초월 논란…美 교통당국 FSD 자율주행 전면조사 돌입

-

[빅테크칼럼] 테슬라, 휴머노이드 로봇 ‘옵티머스’로 ‘지속가능한 풍요’ 시대 선언…연간 100만대 생산 목표

-

[빅테크칼럼] xAI의 4번째 그록 컴패니언 '미카' 등장…푸른 머리·가죽 재킷·반항아 캐릭터·립스틱 대신 오토바이

-

[빅테크칼럼] 태국 정부, AI거물 올트먼 ‘월드 코인’ 홍채 스캔 사이트 급습…암호화폐 불법거래 단속

-

[빅테크칼럼] 테슬라, 2026년 FSD 사이버캡 대량생산 선언…시장의 의구심·강력한 경쟁자·규제 리스크 '3중고'

-

[이슈&논란] SK家 대법원 이혼판결에 노소영 "지금 말씀드리는 건 적절치 않아"…AI기술 만능주의 한계 '지적'

-

[이슈&논란] HD현대·코오롱그룹, 2025 임원 인사…"조직 안정과 세대교체로 미래 전략 가속"

-

[The Numbers] 맥킨지, 은행들이 AI 혼란으로 1700억 달러 손실 가능성 '경고'… AI 혁신에 직면한 글로벌 은행

-

[빅테크칼럼] 유럽 에어버스·탈레스·레오나르도, '우주 삼국동맹'…스타링크에 '도전장' 던졌다

-

[이슈&논란] 홍삼세트 뚜껑 열자 현금 2000만원…강호동 농협회장 선거 '답례' 뇌물 '의혹'

-

[빅테크칼럼] 메타, 위험관리·FTC 준수 부서의 인간 직원을 AI로 대체…‘AI가 감시자의 자리에’

-

[빅테크칼럼] 한국, 글로벌 AI 전쟁터로 급부상…오픈AI·코히어 이어 앤트로픽 ‘서울 영입’ 러시

-

[빅테크칼럼] 머스크 "AI와 로봇이 모든 일자리 대체, 일은 선택사항 될 것"…아마존 60만 일자리 로봇으로 대체

-

[우주AtoZ] 스페이스X, 만번째 스타링크 위성 발사로 '우주 인터넷 혁명' 가속화…"재사용 로켓으로 발사비용 대폭 절감"

-

[빅테크칼럼] AWS 대규모 장애에 전 세계 디지털·AI 초토화…"클라우드 의존성의 민낯"

-

[이슈&논란] 한국마사회, ‘금지약물’ 사용한 경주도 인정…서천호 “공정성 중요한 경주에서 신뢰 붕괴”

-

[The Numbers] HD현대로보틱스, 1800억 투자 유치로 기업가치 1.8조…피지컬 AI 로봇 개발 박차

-

[이슈&논란] 560일 중 40일 출근해 5억 챙겼다…강호동 농협회장, 농민신문사 사장 편법 겸직 '논란'

-

[이슈&논란] 트럼프家 '크립토 제국'…바이낸스 창립자 사면이 불러온 미국 암호화폐 '정경유착' 논란

-

[우주AtoZ] "로봇기반 우주정거장 목표" KAIST, 우주 연구센터 출범…10년동안 712억원 투입

-

[공간사회학] 한가족 된 대한항공·웨스트젯, ‘좌석 논란’으로 시끌…의자 좁아지고 등받이 요금화 '비행기 내 적정공간은?'

-

[공간사회학] 변기 1개에 25명, 교도소 독방보다 좁고 숨 막히는 해군 잠수함…"3년간 240명 승조원 전역 급증, 처우개선 시급"

-

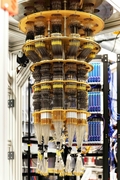

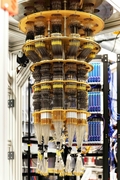

[빅테크칼럼] 구글, 세계 최초 ‘검증 가능한 양자 우위’ 달성…슈퍼컴 대비 1만3000배 속도 ‘퀀텀 에코스’ 알고리즘 개발

-

[빅테크칼럼] 오픈AI, 애플 출신 창업자 스타트업 ‘SW 애플리케이션스’ 인수…맥 전용 AI 인터페이스 ‘스카이’ 챗GPT에 통합

-

[The Numbers] 대한항공, 캐나다 2위 항공사 웨스트젯 지분 10% 인수…조원태 회장 이사 선임으로 북미·중남미 시장 공략

-

[핫픽] 불아더 vs 쉬어가는 개구리 잡화점, 재치대결 간판전쟁…상상력과 유머가 만드는 상권의 힘

-

Hanwha Solutions CEO Kim Dong-kwan's Subsidiary Under Police Investigation for Alleged Technology Misappropriation

-

The cause of the fire at the National Information Resources Service is attributed to LG Energy Solution's lithium-ion battery, with the suspected factors being a combination of aging and human error during work.

-

Hyundai Motor Group Chairman Chung Euisun’s eldest son steps to the forefront of the Japanese subsidiary’s management, overcoming controversies; past DUI incidents spark widespread speculation.

-

Youngone Corp. Tops Diversity Index for Second Year in a Row

-

[기사제목] 선박도 무인 자율운항 시대…美 사로닉-엔비디아, AI 기반 해양 자율운항 선박 개발

-

[우주AtoZ] 일본 대형로켓 H3 7호기, 신형 무인 보급선 HTV-X 첫 탑재 발사 성공…ISS 향한 3일간 비행 시작

-

[우주AtoZ] NASA, 맨해튼 크기의 혜성에서 외계 신호 추적… 외계 가능성 놓고 세계 과학계 긴장

-

[이슈&논란] 美 쉴드 AI, 수직 이착륙 AI 전투기 'X-BAT' 공개…'공중전 패러다임' 바꾼다

-

[우주AtoZ] "로봇기반 우주정거장 목표" KAIST, 우주 연구센터 출범…10년동안 712억원 투입

-

[공간사회학] 한가족 된 대한항공·웨스트젯, ‘좌석 논란’으로 시끌…의자 좁아지고 등받이 요금화 '비행기 내 적정공간은?'

-

[공간사회학] 변기 1개에 25명, 교도소 독방보다 좁고 숨 막히는 해군 잠수함…"3년간 240명 승조원 전역 급증, 처우개선 시급"

-

[이슈&논란] 마드리드에서 실종된 피카소 그림 찾았다…1919년作 ‘기타가 있는 정물화’ 실종 아닌 누락

-

[빅테크칼럼] 사우디아라비아, 5000억 달러 네옴 메가시티에서 AI 투자로 오일머니 이동…"석유경제 탈피, 기술경제 다각화"

-

[공간혁신] 佛 이브 클랭, 독보적 파란 단색화 ‘California' 308억원 낙찰…"미술계 경매 새 기록"

-

[공간혁신] 80년간 보물창고 감춰졌던 피카소 ‘꽃 모자 여인’, 500억원에 낙찰…"올해 파리 경매 최고가"

-

[공간사회학] 독도의 날(10월 25일)에 알아본 작은 섬이 품은 거대한 의미·흥미·재미 13가지

-

[지구칼럼] '은행나무' 관찰·성찰·통찰…가로수 1위·암나무만 열매·은행털이(?)기계·멸종위기종·암수감별·성전환수술(?)·神木

-

[지구칼럼] 런던 지하철 모기, 지하철 터널이 아닌 고대 이집트에서 유래?…도시 진화 신화 뒤집다

-

산업·유통

오픈AI 코리아 초대 대표, 김경훈 전 구글코리아 사장 선임

[뉴스스페이스=이종화 기자] 오픈AI는 초대 오픈AI코리아 총괄 대표로 김경훈을 선임했다고 29일 발표했다. 김 대표는 20년 이상 글로벌 IT·컨설팅 업계를 이끌어온 경영자로, 한국에서 오픈AI의 전략적 협력과 AI 생태계 확장을 총괄하게 된다. 이번 임명은 한국에서 오픈AI 기술에 대한 수요가 빠르게 확산되고 있는 흐름에 맞춰 이뤄졌다. 한국에서 챗GPT는 지난해 대비 주간 활성 사용자 수(Weekly Active Users)가 4배 이상 증가하며, AI 도입과 혁신을 선도하는 허브로 부상하고 있다. 김경훈 신임 대표는 2021년부터 최근까지 구글코리아 사장을 역임하며 한국 내 구글의 광고 사업을 성장시키고 조직 전반을 이끌었다. 또한 다양한 개발자 및 스타트업 지원 프로그램을 통해 국내 AI·디지털 생태계를 확장시키는 데 기여했다. 이전에는 구글 마케팅 솔루션 한국 총괄, APAC 전략·운영 총괄 등을 거치며 모바일 광고, 검색 광고 등 다양한 영역에서 성장을 견인했다. 또한 베인앤컴퍼니 서울 오피스에서 ICT·소비재·제조업 등 다수 기업의 전략 프로젝트를 수행한 바 있다. 서울대학교 컴퓨터공학과를 졸업하고, 미국 듀크대학교에서 MBA 학위를 취득한 김

-

산업·유통

구자은 LS 회장, "국제 정세 변화 속에서 기회를 포착하고 그 파도를 타라" 주문…LS Future Day 개최

[뉴스스페이스=조일섭 기자] LS그룹이 9월 26일, 안양 LS타워에서 ‘힘에 의해 재편되는 세계’를 주제로 그룹의 미래 준비와 혁신 역량을 공유하는 ‘LS Future Day’를 올해로 4회째 개최했다. 이번 행사에는 구자은 LS그룹 회장을 비롯한 각 계열사 CEO, COO(최고운영책임자) 등 임직원 200여 명이 참석했으며, 신사업에 대한 아이디어와 연구개발 최고 성과 사례 등을 공유하고 시상하는 시간을 가졌다. AI 데이터센터향 케이블 개발, 양자기술 기반의 센서 설루션 구축 등 각 사의 20개 프로젝트가 발표됐으며, 이중 우수사례로 선정된 임직원은 ‘LS Futurist’로 선발돼 내년도에 최신 기술 트렌드를 경험할 수 있는 세계 최대 국제전자제품 박람회(CES 2026) 참관 기회가 주어졌다. 구 회장은 이날 임직원 격려사에서 “강대국들의 탈세계화, 자국 우선주의 등 세계 질서가 크게 변화하고 있는 상황에서, 우리는 과거 플라자합의, IMF 위기 등을 통해 이 시기의 대응방법에 따라 기업의 성공과 몰락이 좌우된다는 역사적 교훈을 알고 있다”며, “새로운 산업 질서 속에서, LS의 성패(成敗)도 지금에 달려있다”고 말했다. 이어 그는 “오늘 LS 퓨처

-

우주·항공

NASA 출신 존 리 우주항공본부장, 10월 말 사직…과학계 ‘예고된 인사 참사’

[뉴스스페이스=김시민 기자] 존 리 우주항공청 우주항공임무본부장이 개인 사유로 10월 24일 자로 사직 의사를 공식 표명했다. 2024년 5월 제1대 우주항공임무본부장으로 취임한 지 약 1년 4개월 만이다. 우주청은 후임자가 임명될 때까지 NASA 출신 김현대 항공혁신부문장이 중심이 되어 업무 공백 최소화에 나설 계획이다. 존 리 본부장은 NASA에서 29년간 근무하며 헬리오피직스 프로젝트 관리자, NASA 고더드 우주비행센터 위성통합본부장 등의 요직을 역임했다. 미국계 한국인으로 백악관 행정예산국에서도 예산 관리 경력을 쌓았다. 지난해 우주항공청 출범과 함께 R&D를 총괄하는 임무본부장에 임명돼 우주항공청 안착에 기여했다는 평가가 있다. 그러나 그의 리더십은 내부에서 소통 부재와 조직 내 이견, ‘왕따’ 논란에 휩싸이며 논란을 빚었다. R&D 방향성 문제를 두고 내부 직원과 갈등을 빚었고, L4 탐사 프로젝트 등 주요 사업에서 의견 대립이 있었다는 전언이다. 이에 더해, 존 리 본부장은 미국 법무부의 외국대리인등록법(FARA)에 따라 외국 정부를 위해 활동하는 자로 등록돼 활동 내역을 정기적으로 보고하는 등 복잡한 법적·정치적 문제도 안고 있

-

산업·유통

이재현 CJ 회장, 유럽 현장경영으로 신성장동력 찾는다…“K웨이브 놓치지 말고, 글로벌 영토확장 속도 높여야”

[뉴스스페이스=김희선 기자] 이재현 CJ그룹 회장이 영국 런던을 찾아 유럽 사업 확대 가능성을 점검하고 미래 성장동력 확보에 나섰다. 지난 4월 일본, 8월 미국에 이어 유럽까지 이어지는 글로벌 행보로, 세계 시장에서 신영토 확장을 가속화하려는 의지로 풀이된다. 이 회장은 지주사 및 계열사 주요 경영진과 함께 지난 9일부터 런던을 방문했다. 이미경 CJ 부회장, 김홍기 CJ주식회사 대표, 윤상현 CJ ENM 대표, CJ ENM 정종환 콘텐츠·글로벌사업 총괄 등 그룹 핵심 경영진이 동행했다. 이 회장은 지난해 사우디아라비아 방문을 시작으로 올해 일본과 미국을 방문하며 글로벌 현장 경영을 본격화했다. 이재현 회장이 유럽 지역에서 현장경영에 나선 것은 이번이 처음으로, 그룹의 글로벌 영토 확장에서 유럽이 갖는 중요성을 강조한 행보다. 이 회장은 “글로벌 리딩 컴퍼니로 도약하기 위해 유럽 지역을 포함한 신영토 확장을 가속화해야 한다”며 “그룹의 글로벌 사업 거점인 미국에 이어 잠재력이 큰 유럽 시장에서 신성장 기회를 적극 발굴해야 한다”고 말했다. 특히 이 회장은 현지 임직원을 만난 자리에서 “유럽 지역에서 전방위로 확산하는 K웨이브를 놓치지 말고, 현지 시장을 빠

-

공간·건축

[핫픽] 불아더 vs 쉬어가는 개구리 잡화점, 재치대결 간판전쟁…상상력과 유머가 만드는 상권의 힘

[뉴스스페이스=이종화 기자] 서울 골목에 자리잡은 ‘불아더’와 ‘쉬어가는 개구리 잡화점’. 이 두 곳의 간판은 단순한 상호명 이상의 의미와 재미, 그리고 지역 상권의 상상력을 보여주는 대표적 사례다. 간판을 통해 드러나는 창업자의 센스와 유머, 그리고 도시의 아이덴티티까지 보여준다. 이색 간판은 소비자와 창업자 모두에게 단순 상호명을 넘어서 커뮤니케이션의 매개가 된다. 연구에 따르면, 독특하고 유쾌한 간판은 창업자의 브랜드 스토리텔링 역량을 평균 28% 강화하고, 동네 상권 활성화에 기여한다는 것이 수치로 확인됐다.

-

경제·부동산

[핫픽] “전세 구하려면 면접까지? 급여명세·신용점수 900점은 기본"…전세품귀로 임차인 스펙시대 '서류리스트'

[뉴스스페이스=이종화 기자] 서울 강남의 한 부동산 중개소 앞. ‘전세 매물 없음’ 문구가 붙은 창문 아래로, 긴장한 표정의 30대 직장인이 서류철을 꼭 쥐고 있다. 급여명세서, 신용점수, 국세 완납증명서, 심지어 ‘임차인 자기소개서’까지. 요즘은 집을 ‘보는 게 아니라 집주인에게 보이는’ 시대다. 조만간 펼쳐질 한국 전세 부동산 시장의 모습이다. 최근 온라인 부동산 커뮤니티에서는 ‘임차인 면접 서류 리스트’라 불리는 문서가 화제다. 이 서류에는 회사 PT자료, 신용점수(900점 이상), 범죄사실증명서, 반려동물 금지 서약서, 계약갱신권 포기 각서 등까지 포함돼 있다. 일부 집주인은 “화장실 인테리어를 해주면 우선권을 주겠다”는 조건까지 내건다. 시중 전세 물량이 급감하면서 ‘좋은 세입자 모시기’ 경쟁이 역전돼 ‘좋은 집주인에게 선택받기’ 경쟁으로 바뀐 셈이다. 2030세대 사이에서는 “이젠 집이 아니라 면접에 합격해야 이사 간다”는 자조 섞인 말까지 나온다. 전문가들은 정부의 금융규제 여파로 전세 공급이 줄면서 이런 현상이 일시적 과열 양상으로 나타나고 있다고 분석한다. 하지만 임대차 시장이 신용·직업·가족관계까지 기준으로 삼는다면, ‘임차인 스펙사회’라는

-

Culture·Life

[핫픽] "다윗과 골리앗 신발이 나란히"…일상 속 스며든 상상력의 충돌

[뉴스스페이스=이종화 기자] 도심 가게에서 '다윗과 골리앗'이 신발로 다시 만났다. 작고 평범한 운동화와 키만큼 거대한 흰색 크록 슈즈가 한 줄로 선 장면은, 보는 이에게 즉각적으로 이야기를 떠올리게 한다. 실용적인 데일리 운동화, 그리고 상상 속 판타지를 닮은 대형 크록 신발. 두 신발은 마치 현실과 꿈의 경계에서 맞서듯 조용히 자리를 지키고 있다. 이 대형 크록 신발은 최근 소비와 체험의 경계가 허물어진 시대에 어울리는 상징물이다. 단순 전시 오브제에서 나아가, 인증샷을 찍으려는 시민들로 시장 한구석이 작은 포토존으로 탈바꿈됐다. 일상의 작은 가게에 등장한 거대한 크록 신발은, 우리 소비문화에 유머와 상상력의 여백을 더한다. 다윗과 골리앗처럼 전혀 다른 스케일의 두 신발이 나란히 놓인 풍경은 우리에게 선택의 재미, 그리고 익숙함에 질문을 던지는 상상력의 힘을 다시금 일깨운다. 작고 실용적인 운동화 곁에 놓인 거대한 신발은 현실과 비현실의 조화를 상기시키며, 각자에게 '내가 신을 신발은 무엇인가'라는 묵직한 질문을 던진다. 그리고 또 한번 우리는 스스로에게 묻는다. "정말 이걸 신는 사람이 있을까?"

-

Culture·Life

[핫픽] 이 포도의 이름은? '보고싶 포도 참아'…하나로마트, "재미는 플러스·가격은 마이너스"

[뉴스스페이스=이종화 기자] “보고싶포도 참아.” 이 절묘한 조합의 상품명을 보는 순간, 마치 달콤한 과일 속에 사랑 고백이 숨겨진 듯한 느낌이 든다. 하나로마트 진열대에서 이 포도 봉지를 발견한 소비자는 잠시 멈춰 선다. ‘널 보고 싶포도, 참아야만 해…’ 과일 앞에서 나도 모르게 입가에 미소가 번진다. 최근 과일 시장엔 유쾌한 네이밍 트렌드가 확산 중이다. 유통업계는 “‘보고싶포도 참아’처럼 가볍게 웃을 수 있는 상품명이 구매 욕구와 선물 수요를 동시에 자극한다”고 분석한다. 과일이 단순히 ‘먹는 것’에서 ‘감정 교류’로 확장되는 시대, 봉지를 열 때마다 유쾌한 소통이 시작된다.

1

1

2

2

3

3

4

4

5

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

1

1

2

2

3

3

4

4

5

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

1

1

2

2

3

3

4

4

5

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50